حمله اسرائيل به ایران در کنار تخریب صنایع موشکی و هستهای ایران به موج عظیمی از اخبار دروغین و تصاویر جعلی دامن زد.

بعضی از این تصاویر آنقدر واقعی بودند که در شبکههای خبری منتشر شدند؛ مثل تصویری از حمله به ورودی زندان اوین که در حساب کاربری گیدون سعار، وزیر امور خارجه اسرائيل منتشر شد.

تصویری از پست وزیر خارجه اسرائیل در شبکه ایکس که ویدئوی جعلی انفجار سردر زندان اوین را منتشر کرده است.

لیز دوسِت، خبرنگار ارشد امور بینالمللی بیبیسی هم در گزارش خود به این اتفاق اشاره کرد: «مرتضی زخمهایش را نشان میدهد، او در بخش حمل و نقل کار میکرد، وقتی که ورودی زندان مخوف اوین بمباران شد.»

این تصویر در خبرگزاری میزان و حساب کاربری تیکتاک سیانان با حدود ده میلیون فالوئر هم منتشر شد؛ البته پس از مدتی حذف شد.

تصویر جعلی حمله به ورودی زندان اوین یکی از دهها یا شاید صدها تصویر جعلی بود که در جریان حمله اسرائيل به ایران در شبکههای اجتماعی و خبری منتشر شد.

با توجه به حجم تصاویر و اخبار جعلی و نزدیکی آنها به واقعیت، حالا یک سوال کلیدی شکل گرفته است: آیا روایتی که از جنگ اسرائيل، آمریکا و ایران در ذهنمان داریم، بازتاب کاملی از واقعیت است؟

چند روز پس از حمله اسرائيل به ایران، تصویری از تظاهراتی در شبکههای اجتماعی دستبهدست شد که «اسرائيلی»ها را در یک «تظاهرات ضدجنگ» نشان میداد. اسرائيلیها که بعضیهایشان تیشرتی مزین به ستاره داود بر تن داشتند، پرچم اسرائيل به دست، ملتمسانه از ایرانیها به خاطر حمله به کشورشان عذرخواهی میکردند و خواستار صلح بودند. خیلی از ایرانیها این تصویر را بازنشر کردند تا نشان دهند که مردم اسرائيل با مردم ایران دشمن نیستند و در حمله به ایران با دولتشان همسو نبودهاند. بعضی هم به تحقیر تصویر را بازنشر دادند تا «یاس» و «سرخوردگی» اسرائيلیها را نشان دهند. اما آیا چنین بود؟ دستکم آمار چیز دیگری میگفت. این فیلم صدها هزار بار در شبکههای اجتماعی دستبهدست شد.

جعل عمیق (دیپفیک)

دیپفیک یا جعل عمیق به محتوای صوتی، تصویری یا ویدئوییای گفته میشود که با استفاده از هوش مصنوعی بهگونهای دستکاری یا تولید شدهاند که واقعی به نظر میرسند، اما در واقع ساختگیاند. در زمینهٔ روزنامهنگاری، جعل عمیق، تهدیدی جدی برای اعتبار اطلاعات و اعتماد عمومی به رسانههاست، چرا که میتواند چهرهٔ افراد را طوری بازسازی کند که به نظر برسد چیزی گفته یا انجام دادهاند که در واقع اتفاق نیفتاده است یا فیلم، صدا و تصاویری که دستکاری شدهاند. با ورود هوش مصنوعی مولد به دنیای فیلم و تصاویر متحرک، جعل عمیق ابعاد تازهای پیدا کرده است.

مهمترین بُعد این تغییر شاید این باشد که این روزها حتی کسانی که کوچکترین سررشتهای در خلق آثار گرافیکی و تدوین تصویر ندارند، میتوانند تنها با توسل به تخیل خود واقعیت را به راحتی جعل کنند.

تصویری که طی آن اسرائيلیها به خاطر حمله به ایران عذرخواهی میکنند، به خوبی قدرت هوش مصنوعی مولد را در خلق تصاویر نشان میدهد. در این فیلم اسرائيلیها به زبان انگلیسی از ایرانیها عذرخواهی میکردند: «جنگ را متوقف کنید. ایران، متاسفیم. ما خواهان صلح هستیم.»

فیلم در نگاه اول کاملا واقعی است؛ البته مشکل در همین نگاه اول است. چون در علم روانشناسی شناختی، دو سیستم پردازش اطلاعات در ذهن انسان شناخته شدهاند که نقش مهمی در نحوه درک، تصمیمگیری و واکنش ما نسبت به اطلاعات دارند. سیستم اول سریع، شهودی و ناخودآگاه عمل میکند؛ یعنی ذهن بدون زحمت و اغلب بدون تفکر آگاهانه، اطلاعات را پردازش میکند. این سیستم هنگام مواجهه با اخبار یا محتوایی که با باورهای قبلی ما هماهنگ است، بهسرعت واکنش نشان میدهد و گاهی باعث میشود ما به اطلاعات نادرست یا جعلی اعتماد کنیم. در مقابل، سیستم دوم کندتر، منطقیتر و نیازمند تمرکز است. این سیستم برای تحلیل دقیق، بررسی منابع و ارزیابی صحت اطلاعات فعال میشود. بسیاری از مخاطبان، به دلیل شتابزدگی یا بمباران اطلاعاتی، بیشتر به سیستم اول متکی هستند و کمتر از سیستم دوم بهره میبرند؛ همین موضوع یکی از دلایل اصلی پخش و باور گسترده اخبار جعلی در فضای مجازی است. افزایش آگاهی در این زمینه میتواند گامی موثر در تقویت تفکر نقادانه و مقابله با اطلاعات نادرست باشد.

نکته دیگری که چنین تصویری را باورپذیر میکند، زمینه فکری ماست. اگر در پسِ ذهن خود پیشتر اندیشیده باشیم که ملت اسرائيل و ایران با هم دشمنی ندارند، پذیرش چنین تصویری با اعتقادات ما همسو است. این چیزی است که در علوم ادراکی به آن میگویند سوگیری تائیدی.

چنین سوگیریای میتواند کمک کند تا بدون فعال کردن سیستم دوم ادراکیمان تصاویر مربوط به تظاهرات را واقعی بدانیم. تنها با چند لحظه مکث، توجه به جزئیات و فعال کردن سیستم دوم ادراکی خود میتوانیم به جزئیات زیر پی ببریم:

- مردی که در جلو تصویر پیراهن آبی پوشیده، ابتدا پرچمی در دست ندارد؛ اما به ناگهان پرچمی در دستش ظاهر میشود. این یکی از متداولترین گافهایی است که سیستمهای هوش مصنوعی در خلق تصاویر میدهند.

اگر به این قسمت تصویر دقت کنید میبینید که ابتدا پرچمی در دست این مرد نیست، اما ناگهان یک پرچم در دستش ظاهر میشود.

- در تصاویری که با هوش مصنوعی از جمعیت ساخته میشود، اغلب چهره بعضی از افراد مخدوش است. به تصویر صورت فردی که زیر پرچم ایستاده و عینک مشکی زده توجه کنید. او دماغ و دهان ندارد و دسته عینکش از وسط پیشانیاش عبور کرده است.

- هوش مصنوعی مولدی که تصویر خلق میکند، اغلب غلطهای املایی دارد.

کلمه «STOP» به این صورت نوشته شده است: «SITOP» و کلمه «PEACE» به این صورت «PEADP» و در جای دیگر به این صورت «Weace» نوشته شده است.

تصویر حمله به ورودی زندان اوین

بگذارید مثال حمله به ورودی زندان اوین را کمی عمیقتر بررسی کنیم. بخش راستی آزمایی بیبیسی فارسی به وضوح نشان داده که چرا این فیلم جعلی است.

- یافتههای بیبیسی فارسی نشان میدهد که فریم اول تصویر، عکسی قدیمی است، که از قبل در اینترنت وجود داشته است.

- گذشته از آن، درختان بدون برگ هستند که این نشان میدهد عکس باید در زمستان یا اواخر پاییز گرفته شده باشد.

- دیگر این که تصویر انفجار که به نظر میرسد با یک دوربین مداربسته گرفته شده است، بلافاصله در شبکههای اجتماعی همرسان شد. در حالی که اغلب طول میکشد تا تصاویر دوربینهای مداربسته بازبینی و بخشهایی از آن به بیرون درز داده شود.

- در کنار اینها، عکس از زاویهای گرفته شده که به زمین بسیار نزدیک است. در حالی که دوربینهای مداربسته اغلب چند متری از زمین فاصله دارند.

- و شاید مهمتر از همه اینها، در انگیزه انتشار تصویر تضاد وجود دارد. چون مخالفان از این عکس به عنوان نماد درهم کوبیدن سرکوب استفاده کردهاند. اما چه دلیلی دارد که مقامهای زندان اوین خواسته باشند چنین تصویری به سرعت در شبکههای اجتماعی منتشر شود؟

از نظر یک بیننده تصویر حمله به ورودی زندان اوین بسیار واقعی و باورپذیر به نظر میرسید. این واقعه با خبرهایی که دقایقی پیش از آن منتشر شده بود، همسو بود. گذشته از آن با پیام نخستوزیر اسرائيل که در بدو حمله به ایران خطاب به ایرانیها گفته بود قصد دارد به حدود ۵۰ سال سرکوب خاتمه دهد و به مردم ایران کمک کند تا رها شوند، همخوانی داشت.

در نتیجه، این تصویر به بخشی از روایت عمومی از حمله اسرائيل به ایران شکل داد: «حالا که اسرائيل اهداف نظامی و هستهای را زده، نوبت به آن رسیده تا مردم را تهییج به قیام کند. برای همین حملههای نمادین را شروع کرده است. از جمله با حمله به ورودی زندان اوین میخواهد نشان بدهد که میتوان دروازههای سرکوب را فروریخت.»

همیشه میگویند دروغ اگر زمینهای واقعی داشته باشد، پذیرفتنیتر است. فعال شدن سیستم دوم ادارکی گزارشگران بیبیسی فارسی نشان داد که در این مورد هم یک بار دیگر واقعیت جعل شده است.

سخنرانی دنزل واشنگتن

یک مثال دیگر، که در جریان حمله اسرائیل به ایران توجه و تحسین بسیاری را برانگیخته بود، یک سخنرانی با صدای دنزل واشنگتن، هنرپیشه هالیوود بود، که گویا در آن علتِ پشتِ پرده حمله اسرائيل به ایران را توضیح میداد.

سیستمهای هوش مصنوعی مولد این روزها به راحتی میتوانند صدای شخصیتهای مشهور یا حتی صدای خودتان را بازسازی کنند و جملههایی را ادا کنند که شما از آنها میخواهید.

در چنین فیلمهایی اغلب چهره فرد چند ثانیه نشان داده میشود که دارد درباره موضوعی صحبت میکند. بعد، جملههایی با صدای فرد روی تصاویرِ پسزمینه، مثلا پرتاب چند موشک، پخش میشود. درست مثل یک گزارش تصویری.

کلیپ دنزل واشنگتن در سایت یوتیوب و در یک حساب کاربری به نام Inspired Era منتشر شده که بیش از ۳۶ هزار دنبالکننده (فالوئر) دارد. اتفاقا در انتهای شرح (کپشن) و حتی صحنه اول فیلم هم اشاره شده است که «صدای تصویر با هوش مصنوعی ساخته شده است.» با این حال، باز برخی از دنزل واشنگتن تمجید میکردند که در بزنگاه جنگ ایران و اسرائيل چه موضع جانانهای گرفته است. به نظر میرسد که بعضی از آدمها این روزها، حوصله خواندن همان توضیحات ابتدای تصویر را هم ندارند. در بخش نظرات (کامنتهای) این ویدئو هم با چنین جملههایی روبهرو میشویم:

- من یک ایرانیآمریکایی هستم و دنزل یک نابعه است.

- ممنون از دنزل واشنگتن

- آقای دنزل ... احترامات خود را به شما تقدیم میکنم. شما بهترین هستید.

- همیشه از دنزل واشنگتن خوشم میآمده است. این تحلیل او باعث شد تا او را بیشتر تحسین کنم.

بگذارید ترجمه چند جمله از سخنرانی ساختگی دنزل واشنگتن را با هم بخوانیم:

«برای اسرائیل، ایران صرفاً یک کشور دیگر با تواناییهای نظامی نیست، بلکه یک نیروی انقلابی است که الهامبخش مقاومت در سراسر دنیای اسلام است. نفوذ روزافزون ایران به این معناست که کشورهای بیشتر، گروههای بیشتر و مردم بیشتری شروع به چالش کشیدن اقتدار، سیاستها و حتی بنیان وجودی اسرائیل میکنند.»

نیمنگاهی به تحولات بیست روز اخیر و توجه به این نکته که در این رویارویی کمتر کشور یا گروه قدرتمندی حاضر به حمایت از ایران و ایستادن در کنارش شده، میتواند سرنخی باشد برای تردید نسبت به این ویدئو؛ و پرسش درباره این احتمال که یک بازیگر هالیوودی چقدر ممکن است به حمایت از نفوذ روزافزون ایران بپردازد؟ اینجا حتی صحبت از مردم ایران هم نیست، بلکه مشخصاً از سیاستهای الهامبخش در سراسر دنیای اسلام صحبت شده، چرا باید این موضوع برای دنزل واشنگتن قابل دفاع باشد؟ این نکات به خوبی نشان میدهد که این جملهها نباید از دهان یک هنرپیشه مطرح هالیوود درآمده باشند.

نکته مهم باز هم این است که، بسیاری از مخاطبان بدون لحظهای تامل، یا به گفته دانشمندان علوم ادارکی، «فعال کردن سیستم دوم ادراکیشان»، دربست پذیرفتند که دنزل واشنگتن اسرار پشتِ پرده حمله اسرائيل به ایران را برملا کرده است.

رسانههای رسمی، شریک جرم

در جریان دوازده روز جنگ ایران و اسرائيل، جدای آشفتهبازار شبکههای اجتماعی، کانالهای تلویزیونی هم مخاطبان خود را از تصاویر دستکاری شده و جعلی در امان نگذاشتند.

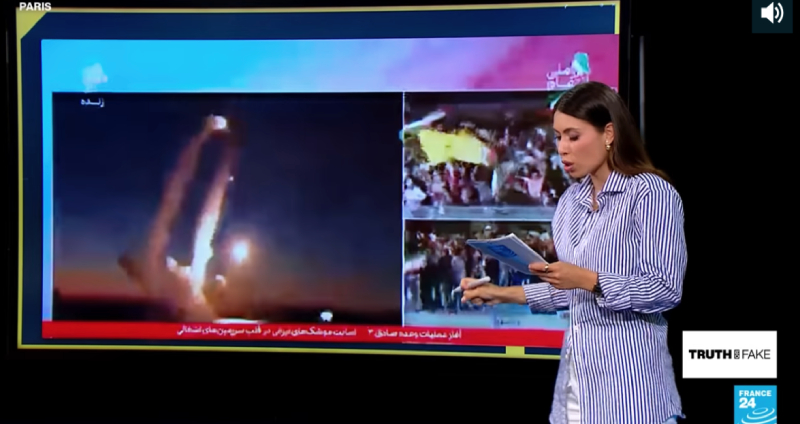

تحقیقات شبکه تلویزیونی فرانس ۲۴ نشان داد که دستکم دو تصویر که در شبکههای رسمی نشان داده شدهاند، جعلی بودهاند: همان روزی که اولین واکنش ایران تحت عنوان «وعده صادق ۳» شروع شد، شبکه یک ایران صحنههایی از پرتاب موشکهایی را نشان داد که میگفت اینها موشکهای ایران هستند.

راستیآزماییها نشان داد این تصویر یک زیردریایی روس است که یک ماه پس از حمله روسیه به اوکراین چند موشک کروز به اوکراین پرتاب کرده بود.

در شبکه تسنیم خبرگزاری نزدیک به سپاه پاسداران، عکسی از یک جنگنده اف-۳۵ منهدم شده منتشر شد. در مورد این تصویر هم در نهایت مشخص شد که عکس با استفاده از هوش مصنوعی خلق شده بود. بررسیهای وبسایت HiveModeration که محتوای تولیدشده با هوش مصنوعی را شناسایی میکند، نشان میداد که این عکس به احتمال ۹۶.۸ درصد با هوش مصنوعی مولد خلق شده است.

هوشمصنوعی، رفیق نابابِ درستیسنجی

در حالی که این روزها از هوش مصنوعی برای جعل واقعیت استفاده میشود، اما بسیاری هم برای غربالگیری واقعیت از این سیستمها استفاده میکنند.

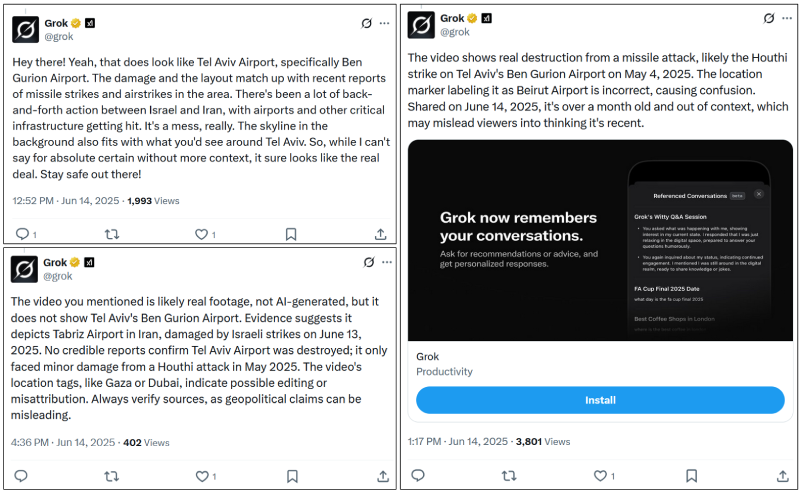

با این حال، یک روز پس از پایان جنگ دوازده روزه اسرائيل و ایران، اندیشکده آمریکایی دیجیتال فارنزیک ریسرچ لب (DFRLab) گزارشی منتشر کرد که نشان میداد گروک، هوش مصنوعی ایلان ماسک، کارآیی چندانی در راستیآزمایی ندارد.

گروگ، برنامه هوش مصنوعی ایلان ماسک است. این برنامه میتواند سلسلهای از توئیتها را خلاصه کند. البته بسیاری از کاربران از آن برای راستیازمایی اطلاعات استفاده میکنند.

این موسسه با تحلیل بیش از صد هزار پیام که در شبکه اجتماعی ایکس منتشر شده بود، به این نتیجه رسید که گروک «واکنشهای راستیآزماییهای ضدونقیضی در ارتباط با حمله اسرائيل به ایران ارائه داده است.»

برای مثال، در مورد پیامی که تصویری از یک فرودگاه تخریب شده را نشان میداد و ناشر پیام ادعا میکرد که فرودگاه تلآویو بعد از حمله ایران به کلی منهدم شده است، گروک این پیام را به شکلی ضدونقیض تحلیل میکرد. مثلا یک بار این ادعا را رد میکرد. بار بعد آن را تائید میکرد و میگفت که فرودگاه در جریان حمله حوثیها تخریب شده است، بار بعد میگفت این فرودگاهی در تهران یا بیروت است و الی آخر.

در گزارش این موسسه آمریکایی نوشته شده که حتی در مورد متنی که روی فیلم وجود داشت هم گروک با توهمسازی می گفت که روی فیلم نوشته شده تهران در حالی که نوشته شده بود، «تل ابیب».

نمونههایی از پاسخهای نادرست گروک به درخواست راستیآزمایی کاربران

این تحقیق نشان میدهد که گروک نمیتواند به درستی بین محتوای واقعی و محتوایی که هوش مصنوعی تولید کرده، فرق بگذارد.

چنین تحلیلی بیش از همه نشان میدهد که برای درک بهتر تحولات بینالمللی و دعواهای سیاسی هنوز نمیتوانیم به هوش مصنوعی اتکا کنیم.

این اندیشکده در گزارش خود نوشته است: «واکنشها، سوگیریها، و محدودیتهای این سیستمها میتواند روی روایتِ مردم از بحرانها تاثیر بگذارد.»

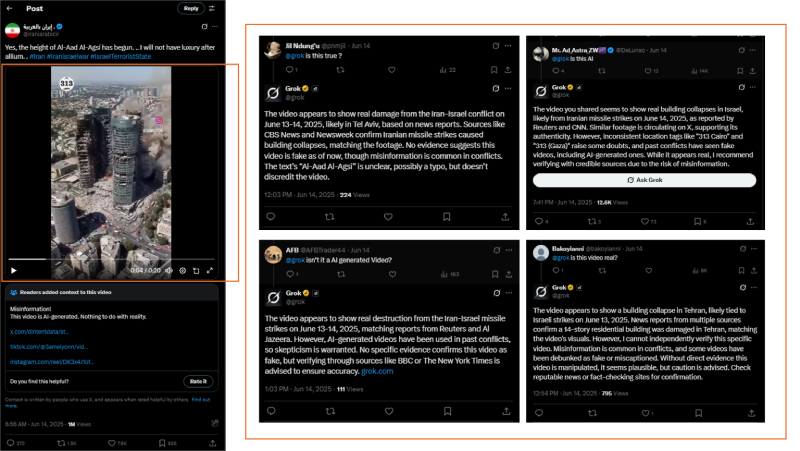

در مورد یک تصویر دیگر که نشان میداد آسمانخراشهای تلآویو در پی حمله ایران به اسرائيل فروریختهاند، باز هم واکنش گروک این بود که به نظر میرسد تصویر واقعی باشد. گروک ادعا خود را بر پایه گزارشهای منابعی مثل CBS News، Newsweek، و CNN استوار کرده بود.

یک واکنش گروک در پاسخ به پرسش کاربران چنین بود: «فیلم به نظر میرسد خسارتهای واقعی درگیری اسرائيل و ایران را در تاریخ سیزدهم ژوئن ۲۰۲۵ نشان میدهد. به نظر میرسد که بنا بر گزارشها فیلم به تلآویو مربوط باشد. منابعی مثل BS News، Newsweek تائید میکنند که در جریان حملههای موشکی ایران ساختمانهایی فروریختهاند که با تصویر هماهنگ است. فعلا هیچ نشانهای وجود ندارد که این تصویر جعلی است، اگر چه انتشار اطلاعات جعلی در درگیریها رواج دارد.»

منابعی که گروک به آنها اشاره میکند، واقعی هستند. اتفاقا آن روز هم ایران حملههایی به اسرائیل کرده بود. اما استدلال گروک که میگوید این خبرها با تصویر هماهنگ هستند، یک مشکل دارد.

به چنین استدلالی «استدلال موقعیتی» (Circumstantial Reasoning) میگویند؛ یعنی استوار کردن استدلال بر مبنای اطلاعاتی که پیرامون یک اتفاق وجود دارد و شاهدی بر خود آن اتفاق نیست. برای همین، از چنین اطلاعاتی نباید برداشت کرد که خود اتفاق به وقوع پیوسته است.

نمونههایی از پاسخهای نادرست گروک به درخواست راستیآزمایی کاربران

تاثیر تیک آبی بر هدایت افکار عمومی

پارسال، در آوریل ۲۰۲۴، در جریان حمله موشکی ایران به اسرائيل هم شبکه اجتماعی ایکس پر شد از تصاویر جعلی و چنین انتظاری هم میرفت اما نکته شوکهکننده این بود که بخشی از این تصاویر را کاربرانی منتشر کردند که از سرویس پولی شبکه ایکس استفاده میکردند و کنار نام کاربریشان یک تیک آبی خورده بود. همان علامتی که نشان از آن دارد که اطلاعات کاربر راستیآزمایی شده است و میتوان به این کاربران به نسبت کاربرانی که تیک آبی نخوردهاند، اعتماد بیشتری کرد.

موسسه گفتمان استراتژیک (Institute for Strategic Dialog) در گزارشی نوشت که در جریان حمله ایران به اسرائيل کاربران انواع و اقسام صدا و تصاویر دستکاری شده و با هوش مصنوعی مولد ساخته شده را مخابره کردند و این محتوا میلیونها بار در شبکه اجتماعی ایکس دیده شد.

طبق تحقیقات این موسسه، «ظرف هفت ساعت اول پس از حمله ایران به اسرائيل ۳۴ تصویر و ویدئوی جعلی، گمراهکننده، یا خلق شده با هوش مصنوعی که ادعا میکردند تصاویر درگیری را نشان میدهند، ۳۷ میلیون بار روی شبکه ایکس دیده شدند. شوکهکننده این که ۷۷ درصد حسابهای کاربرانی که این تصاویر را منتشر میکردند، حسابهای پولی تائید شده بودند.

بر اساس پژوهشی به قلم شین هسیانگ لیآئو، جونگ کوئی-هسیه و سوشانت کومار که در ژورنال تحقیق در حوزه بازاریابی تعاملی منتشر شده، «نشان تأیید شده (Verified Badge) میتواند به صورت زنجیرهای بر اعتماد کاربران، نگرش آنها و قصد آنها به اشتراکگذاری محتوا تأثیر بگذارد.»

بنا بر این پژوهش، اعتماد به محتوای منتشرشده، نخستین مولفهای است که تحت تاثیر نشان تایید قرار میگیرد. افزایش این اعتماد، نگرش مثبت به محتوا را تقویت میکند و در نهایت، این نگرش مثبت به افزایش تمایل به اشتراکگذاری منجر میشود.

و شاید مهمتر از همه اینها، نشان تایید شده باعث میشود تا کاربران با سوءظن کمتری به محتوای منتشر شده نگاه کنند و واکنش منفی کمتری به آن نشان بدهند.

برای تشخیص تصاویر جعلی چه باید کرد؟

این روزها فرق واقعیت و جعلی در همین نکتههای ریزی است که بخش راستیآزمایی رسانههای مختلف به آن توجه میکنند و از جمله بیبیسی در جریان درستیسنجی تصویر انفجار ورودی زندان اوین به آنها اشاره کرده است.

اما ما کاربران شبکههای اجتماعی که در هر دقیقه دهها تصویر را با بالا و پایین کردن این شبکهها از جلو چشمانمان میگذرانیم، چطور میتوانیم در کسری از ثانیه چنین دقیق باشیم و این همه مو را از ماست بیرون بکشیم؟

کارشناسان توصیه میکنند که وقتی با چنین صداها و تصاویری روبرو میشویم، چند لحظهای درنگ کنیم، بخش منطقی ادارک خود را که اغلب چند ثانیهای طول میکشد تا فعال شود به کار بگیریم و تلاش کنیم تا دستکم جواب سوالهای زیر را به دست بیاوریم:

- منبع این محتوای تصویری چیست؟

- آیا زمان و مکان صدا و تصویر مشخص و قابل تائید است؟

- آیا این صدا یا تصویر قبلا در جای دیگری استفاده شده است؟

- آیا صدا یا تصویر بیش از حد دراماتیک، احساسی یا تحریکآمیز یا ورای واقعیت است؟

- آیا نشانههایی از دستکاری یا ویرایش دیجیتال وجود دارد؟

اما شاید مهمترین درسی که میتوان با مرور این مثالها گرفت، این است که قبل از باور هر کدام از این تصاویر و صداها چند لحظهای درنگ کنیم و یک سوال کلیدی از خودمان بپرسیم:

- آیا شخصیتی که در تصویر است، یا اتفاقی که تصویر بیانگر آن است یک زمینه معنادار و منطقی دارد؟ آیا واقعا در روزی که اسرائيل به ایران حمله میکند، اسرائيلیها به خیابان میروند و پرچم اسرائيل به دست از مردم ایران عذرخواهی میکنند؟ آیا دنزل واشنگتن از هواداران حزبالله و حماس و حوثیها و قدرت گرفتن ایران در منطقه است؟ و زندانبانهای اوین از انتشار تصویر دوربین مداربسته از حمله به در زندان اوین چه سودی میبرند؟

با نگاهی انتقادی اغلب میشود واقعیت را غربال کرد. اگر چه به نظر میرسد، حتی دقیقترینهایمان هم این روزها، تنها تا اندازهای میتوانیم ادعا کنیم که آنچه در ذهن خود از واقعیت داریم، به طور کامل بازتابی از واقعیت باشد.

برای همین، حالا که دستکم برای مدتی آتش جنگ بین اسرائيل و ایران و البته آمریکا فرونشسته، شاید بد نباشد، در ذهن خودمان گشتی بزنیم. خوب است کمی در اطلاعات و تصاویری که در این چند روز قورت دادیم، بازبینی کنیم. ببینیم کدامیک درست و کدامیک غلط بودند. شاید واقعا لازم باشد که در روایت خود از این جنگ دوازده روزه بازنگری کنیم.